Ferramentas de Inteligência Artificial podem se prejudicar com conteúdos digitais

Se expostos a conteúdos de baixa qualidade, modelos de IA podem acabar com distorções de raciocínio, criando resultados superficiais e confusos

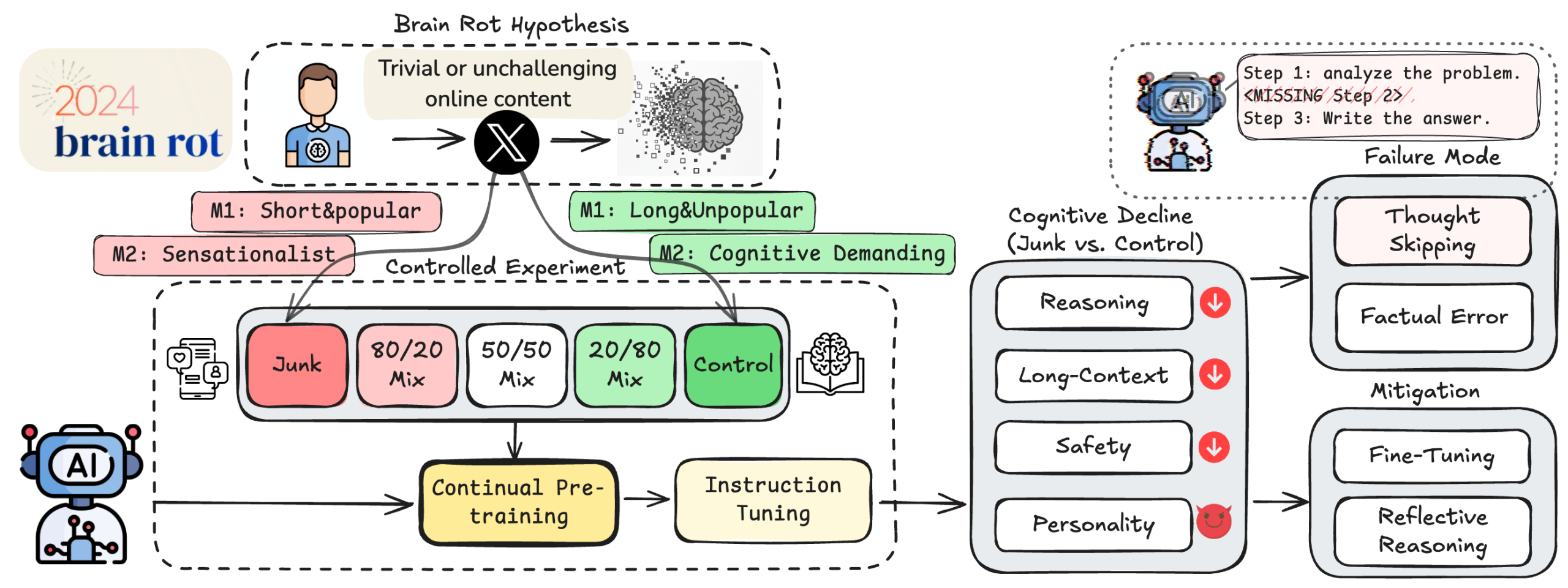

Diversos estudos envolvendo tipos de inteligência artificial vem surgindo nos últimos tempos e uma pesquisa recente, tenta refletir sobre a possibilidade das IAs sofrerem com “Brain Rot” ao serem treinadas com os mesmos conteúdos que os usuários consomem constantemente na internet.

O termo brain rot significa “apodrecimento cerebral” e é usado para explicar como o consumo incessante de conteúdo online afeta o cérebro humano, prejudicando seriamente a cognição humana: o foco, a memória, disciplina e até o discernimento social de alguém vai definhando pouco a pouco. Ano passado, a Oxford University Press chegou a eleger brain rot como “palavra do ano” com o crescimento dos obcecados por telas.

A tese sobre IAs deteriorando suas funções veio de pesquisadores da Texas A&M University em parceria com a Universidade Purdue de West Lafayette, Indiana. Os estudos começaram com a preocupação de que, se as ferramentas de IA “aprendem” com a mesma enxurrada de lixo digital que os humanos se viciam, como fica a construção lógica da programação dessas ferramentas?

Testando a hipótese

Obviamente, modelos de IA não conseguem pensar ou compreender, mas são desenvolvidos para seguir uma lógica e manter a coerência de acordo com suas funções específicas direto em seu código. Se expostos a conteúdos de baixa qualidade, o resultado traz prejuízos em contextos mais longos e principalmente mais complexos, criando “falhas de raciocínio” e inconsistências na resposta dada pela IA.

“Quando expostos a textos de baixa qualidade, os modelos não apenas soam piores, eles começam a pensar pior” Junyuan Hong e Atlas Wang, coautores do estudo, sobre a base do projeto.

Esboço de Hong e Wang (Foto: reprodução/GitHub/LLMs Can Get “Brain Rot”!)

Os pesquisadores testaram sua hipótese com um amontoado de dados “ruins” tirados da plataforma X, o antigo Twitter, com um grande arquivo cheio de publicações “caça-cliques”, comentários reciclados, postagens feitas para causar brigas e uma chuva de textos feitos por bots, os famosos algoritmos programados.

Treinando modelos com esse conteúdo (Llama 3, do Meta e Qwen LLm da Alibaba, ambos IAs de linguagem), houve um declínio cognitivo considerável, causando um impacto duradouro onde as ferramentas parecem fluentes, mas raciocinam de uma forma superficial e confusa.

Vozes sobre a pesquisa

Os resultados não surpreenderam pesquisadores da área, até os que não participaram do projeto. Ilia Shumailov, ex-cientista, afirmou que o brain rot das IAs estão alinhados com a literatura acadêmica sobre envenenamento de modelos, um termo que explica o que acontece quando agentes mal-intencionados manipulam dados de treinamento de IA, trazendo vulnerabilidades e o próprio fim dos modelos.

Gideon Futerman, um associado do Center for AI Safety, também comentou sobre o uso seguro da inteligência artificial e que a melhoria de dados no pré-treinamento delas pode garantir que os sistemas de IA sejam melhores com o tempo.

Higiene Cognitiva

Junyuan e Atlas apelidaram as avaliações de treinamento de IA como “higiene cognitiva” explicando que o futuro da segurança desses modelos depende da integridade dos dados que estão moldando cada ferramenta, ainda mais se até a primeira base delas, é gerada por uma IA.

Para eles, à medida que o conteúdo online fica cada vez mais sintético e focado apenas no engajamento, é um grande risco para os modelos da inteligência artificial herdarem distorções de raciocínio. Uma prévia da pesquisa “Hipótese do Apodrecimento Cerebral das LLMs” está disponível na plataforma arXiv e passa por uma revisão de pares atualmente.