Esquemas de extorsão envolvendo nudes falsos criados através do uso de ferramentas de edição de IA têm se tornado cada vez mais comuns e preocupantes, segundo alerta emitido pelo FBI. De acordo com o departamento de investigação estadunidense, a facilidade com que imagens de nudez falsificadas estão aumentando cada vez mais o número de casos reportados em território nacional e, seguindo esse ritmo, é provável que se torne um problema de grandes proporções.

A criação de tais imagens e vídeos falsos é feita através de imagens comuns que a vítima compartilhou em redes sociais. A partir delas, os golpistas então utilizam ferramentas de IA para criar conteúdos realistas das vítimas, nuas ou em outras situações comprometedoras. “Essas fotos são enviadas diretamente para as vítimas por indivíduos maliciosos com o intuito de extorqui-las, ou simplesmente por assédio”, informou o departamento através de comunicado.

Anúncio do FBI a respeito dos deepfakes e extorsão monetária envolvendo nudes falsos (Divulgação)

O crime de extorsão através de imagens comprometedoras é mais comumente chamado de “sextorsão”, caracterizado pela exposição de material íntimo da vítima em troca de ganho pessoal por parte do golpista. Segundo o documento publicado pelo FBI, uma vez que o material entra em circulação, as vítimas terão grande dificuldade para impedir o compartilhamento incessante e contínuo do conteúdo falsificado pela rede; conseguir a remoção do mesmo de maneira permanente é ainda mais difícil, tendo em vista a natureza da web.

A agência de inteligência recomendou ao público que tome cuidado na hora de compartilhar imagens pessoais em redes sociais, por mais tentador que seja. Através do comunicado, o FBI também reiterou que esse tipo de adulteração precisa apenas de alguns poucos vídeos e imagens através da tecnologia avançada dos tempos atuais e que, portanto, ninguém está completamente a salvo de casos parecidos ou piores, desde que não remova completamente todas as imagens, vídeos e mídia de si mesmo(a) da rede.

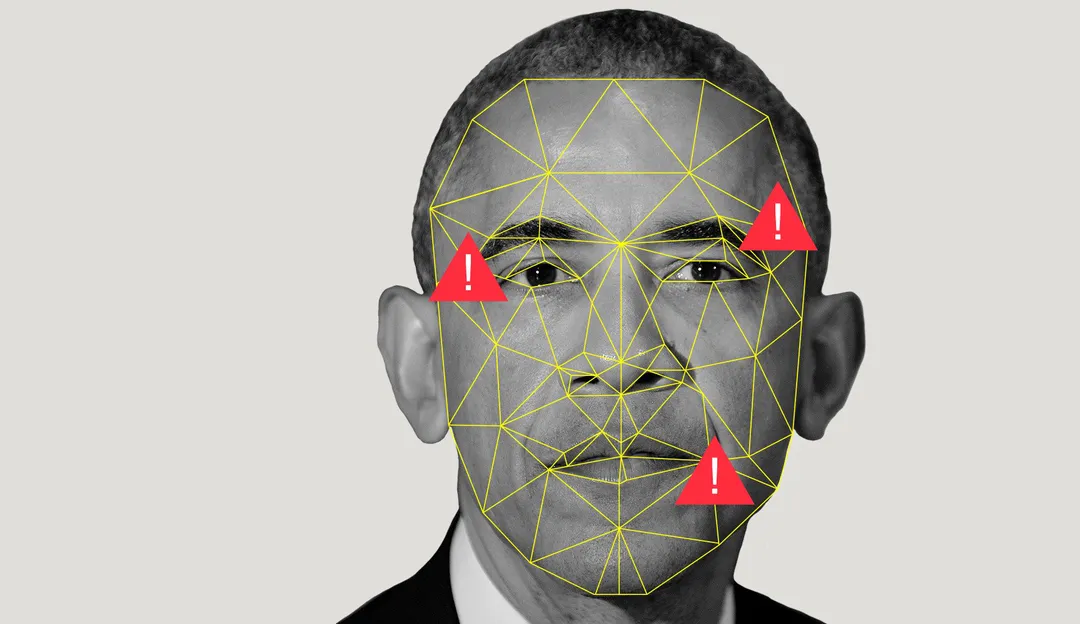

Deepfakes são imagens falsas mas com alto grau de fidelidade, muitas vezes sendo facilmente confundidas com a pessoa real. Segundo o The Verge, mídia desse cunho começou a se espalhar pela internet em 2017, através de usuários de fóruns de discussão populares como o Reddit e o 4chan, que começaram a usar novas ferramentas de inteligência artificial que ainda estavam em estados iniciais de desenvolvimento na época para criar conteúdo explícito de celebridades femininas. Exemplos mais inofensivos do uso da tecnologia também existem, como vídeos no Youtube envolvendo famosos. Um dos mais populares é um deepfake de George Lucas, criador da franquia Star Wars, reagindo negativamente aos filmes da nova trilogia. A impersonificação conta até mesmo com voz falsa do diretor de cinema.

Autoridades governamentais têm tentado regular a criação e a disseminação desse tipo de conteúdo pela rede, mas o avanço na tecnologia tem tornado o deepfake algo cada vez mais fácil de ser feito, dificultando o processo.

Foto destaque: Representação do processo de reconhecimento facial utilizado na criação de Deepfakes, usando o ex-presidente estadunidense Barack Obama como exemplo. (Reprodução/Wired)