Em um mundo onde cada vez mais não é mais acreditar, os especialistas estão alertando que a sociedade deve adotar uma abordagem multifacetada para combater os danos potenciais da mídia gerada por computador.

Como Bill Whitaker relata esta semana no 60 Minutes, a inteligência artificial pode manipular rostos e vozes para fazer parecer que alguém disse algo que nunca disse. O resultado são vídeos de coisas que nunca aconteceram, chamados de "deepfakes". Muitas vezes, eles parecem tão reais que as pessoas que assistem não podem dizer. Apenas neste mês, Justin Bieber foi enganado por uma série de vídeos deepfake na plataforma de vídeos de mídia social TikTok que pareciam ser de Tom Cruise.

Esses vídeos fabricados, batizados com o nome de uma combinação da prática da ciência da computação conhecida como "deep learning" e "fake", chegaram pela primeira vez à Internet no final de 2017. A sofisticação dos deepfakes avançou rapidamente nos quatro anos seguintes, juntamente com a disponibilidade das ferramentas necessárias para fazê-los.

Mas além de entreter usuários de mídia social e enganar cantores pop desavisados, os deepfakes também podem representar uma séria ameaça.

Em um artigo da California Law Review de 2018, os juristas Bobby Chesney e Danielle Citron descreveram os possíveis danos que as deepfakes representam para os indivíduos e a sociedade. Deepfakes, escreveram eles, pode potencialmente distorcer o discurso democrático; manipular eleições; corroer a confiança nas instituições; comprometer a segurança pública e a segurança nacional; prejudicar a reputação; e minar o jornalismo.

A principal ameaça dos deepfakes decorre do fato de as pessoas se convencerem de que algo fictício realmente ocorreu. Mas os deepfakes podem distorcer a verdade de outra maneira insidiosa. À medida que os vídeos manipulados permeiam a internet, pode se tornar progressivamente mais difícil separar o fato da ficção. Portanto, se qualquer vídeo ou áudio puder ser falsificado, qualquer um pode descartar a verdade alegando que é mídia sintética.

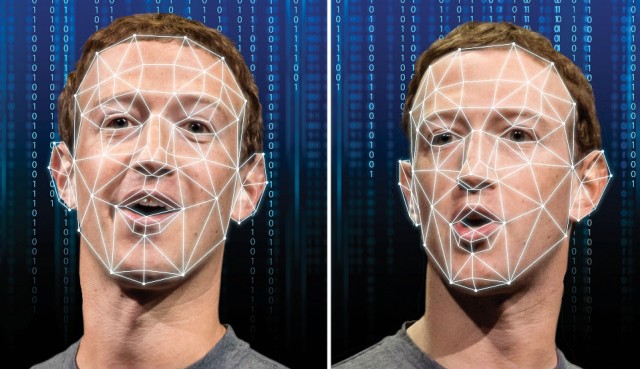

Criação do Deepfake (Foto) Reprodução/weforum.)

É um paradoxo que Chesney e Citron chamam de "Dividendo do Mentiroso".

“À medida que o público se torna mais consciente da ideia de que vídeo e áudio podem ser falsificados de forma convincente, alguns tentarão escapar da responsabilidade por suas ações denunciando vídeo e áudio autênticos como deepfakes”, escreveram. “Resumindo: um público cético será preparado para duvidar da autenticidade de evidências reais de áudio e vídeo”.

À medida que o público aprende mais sobre as ameaças representadas pelos deepfakes, os esforços para desmascarar as mentiras podem parecer legitimar a desinformação, pois uma parte do público acredita que deve haver alguma verdade na alegação fraudulenta. Esse é o chamado "dividendo" pago ao mentiroso.

Um exemplo público disso ocorreu no ano passado, quando Winnie Heartstrong, uma candidata republicana ao Congresso, divulgou um relatório de 23 páginas alegando que o vídeo do assassinato de George Floyd era na verdade um deepfake. O relatório falso alegou que Floyd estava morto há muito tempo.

“Concluímos que ninguém no vídeo é realmente uma pessoa, mas sim composições digitais de duas ou mais pessoas reais para formar pessoas digitais completamente novas usando a tecnologia deepfake”, escreveu Heartstrong no relatório, de acordo com o Daily Beast.

Nina Schick, cientista política e consultora de tecnologia, escreveu o livro Deepfakes. Ela disse ao 60 Minutes que esse conceito de "dividendo do mentiroso" tem o potencial de corroer o ecossistema de informações.

Vídeos, ela apontou, atualmente são evidências convincentes em um tribunal. Mas se os jurados não concordarem com sua autenticidade, o mesmo vídeo pode exonerar alguém – ou mandá-lo para a prisão por anos.

"Nós realmente temos que pensar em como construir algum tipo de segurança para que possamos garantir que haja algum grau de confiança com todo o conteúdo digital com o qual interagimos no dia-a-dia", disse Schick. "Porque se não o fizermos, então qualquer ideia de uma realidade compartilhada ou uma realidade objetiva compartilhada absolutamente desaparecerá."

Foto destaque: Um Deepfake do fundador de META. Reprodução:tekcrispy.